“La cittadinanza a punti (social scoring) non è in linea con i principi di una società democratica”

L’associazione Privacy Network stigmatizza l’uso del cosiddetto “credito sociale cinese”. Preoccupazioni e forti riserve erano state espresse negli scorsi mesi anche dal Garante per la Privacy: “Avviate istruttorie su comportamento enti locali, si valutino con la massima attenzione eventuali future adozioni di progetti di social scoring o di sue derivazioni”

L’Associazione Privacy Network contestualmente alla pubblicazione di un Rapporto su come i partiti politici vedono la tecnologia, ha proposto dei punti programmatici “dei quali tutti i partiti e le coalizioni dovrebbero tenere conto, una volta risolte le questioni politiche più urgenti e quando dovranno essere affrontate queste tematiche”. Questi comprendono una “presa di posizione netta contro i sistemi di riconoscimento facciale, proseguendo nel solco della moratoria di cui al DL 139/2021 ed estendendola in modo da tutelare al meglio i diritti umani. In generale, i processi decisionali automatizzati creati dal pubblico devono necessariamente essere pensati in modo da tutelare al meglio i diritti umani, in modo trasparente e responsabile”.

L’associazione ha inoltre stigmatizzato l’utilizzo del cosiddetto “credito sociale cinese” (o social scoring o “cittadinanza a punti”) affermando che bisogna “prendere una posizione netta contro i sistemi di social scoring. L’adozione di sistemi di valutazione sociale non è in linea con i principi di una società democratica“. Privacy Network ha poi ammonito le istituzioni: “Bisogna pretendere – ha fatto sapere – che i servizi web usati dalle scuole garantiscano i diritti degli studenti e che utilizzino i dati per i soli scopi dichiarati, evitando abusi sui dati e sui diritti dei minori evidenziati anche dallo Human Right Watch”.

Le preoccupazioni del Garante per la Privacy

“I meccanismi di “scoring” – cioè l’assegnazione di un punteggio e relativi premi in base a comportamenti “virtuosi”, ben noti per esempio nell’ambito RCA – cominciano ad essere applicati anche in contesti pubblici e privati del tutto nuovi”, riflette la giornalista Alessandra Schofield. Questo ha, ovviamente, destato le preoccupazioni del Garante per la Privacy, che negli scorsi mesi si esprimeva così:

“Diversi enti locali che stanno mostrando un interesse crescente per iniziative basate su soluzioni di tipo premiale che fanno ricorso a meccanismi di scoring associati a comportamenti “virtuosi” del cittadino in diversi settori (ambiente, fiscalità, cultura, mobilità, sport)”.

“Le istruttorie avviate dall’Autorità, sia d’ufficio sia su segnalazione, riguardano una serie di progetti promossi da soggetti pubblici e privati, che prevedono l’assegnazione di punteggi anche riguardo a raccolte di dati conferiti “volontariamente” dagli interessati. Gli interventi dell’Autorità si sono resi necessari a causa dei rischi connessi a meccanismi di profilazione che comportino una sorta di “cittadinanza a punti” e dai quali possano derivare conseguenze giuridiche negative sui diritti e le libertà degli interessati, inclusi i soggetti più vulnerabili”.

“L’Autorità si riserva l’adozione di eventuali provvedimenti conseguenti ai risultati delle istruttorie in corso. Un’istruttoria appena avviata riguarda il “Progetto Pollicino”, un’indagine statistica a carattere sperimentale – promossa dalla Fondazione per lo sviluppo sostenibile, dal Ministero della transizione ecologica e dal Ministero delle infrastrutture e della mobilità sostenibili – attraverso la quale il cittadino viene invitato a condividere i propri dati (apparentemente “in forma anonima”), per consentire un’analisi della mobilità. Al termine dell’indagine, è previsto che il cittadino riceva premi offerti dai partner privati del Progetto. L’indagine interesserà per primo il Comune di Bologna. L’Autorità ha quindi richiesto chiarimenti alla Fondazione, al Comune di Bologna e ai Ministeri interessati per conoscere, in particolare, il ruolo dei soggetti pubblici e privati coinvolti, la base giuridica del trattamento, le modalità di funzionamento del sistema dell’app e i trattamenti ad essa connessi”.

“Un’altra istruttoria recentemente avviata su temi analoghi ha riguardato l’iniziativa “smart citizen wallet” del Comune di Bologna, nell’ambito della quale è previsto che i cittadini possano aderire su base volontaria ad un sistema che consente di accumulare “crediti” all’interno del proprio “walletC (portafoglio), da spendere accedendo ad una serie di premi/incentivi messi a disposizione dal Comune e da partner accreditati”.

“In precedenza il Garante si è occupato di un progetto avviato dal Comune di Fidenza, che aveva introdotto, con proprio Regolamento, la cosiddetta “carta dell’assegnatario” degli alloggi di edilizia residenziale pubblica. Anche in questo caso, è previsto un meccanismo di scoring associato al comportamento tenuto dagli assegnatari degli alloggi, attraverso un sistema di punteggio finalizzato al riconoscimento di benefici e sanzioni, inclusa la risoluzione e/o la decadenza del contratto di locazione, con possibili conseguenze pregiudizievoli in capo a categorie di soggetti vulnerabili”.

“Nel richiamare tutti gli enti locali a valutare con la massima attenzione eventuali future adozioni di progetti di “social scoring” o sue derivazioni, il Garante ribadisce la necessità che queste iniziative siano sempre e comunque anticipate da puntuali valutazioni di impatto e rispettino i principi fondamentali del Regolamento Ue”, conclude il Garante per la Privacy.

Rec News dir. Zaira Bartucca – recnews.it

TECH

Ecco come l’IA vede i politici italiani

L’Intelligenza artificiale non è nuova a svarioni. Ne abbiamo raccontati alcuni in questo articolo, dove abbiamo parlato dello stress-test con cui abbiamo provato a mettere l’IA davanti ai suoi limiti. Questa volta, invece, abbiamo domandato a un generatore di immagini come vede i politici italiani. Ne è uscita fuori una serie di ritratti verosimili e a tratti esilaranti.

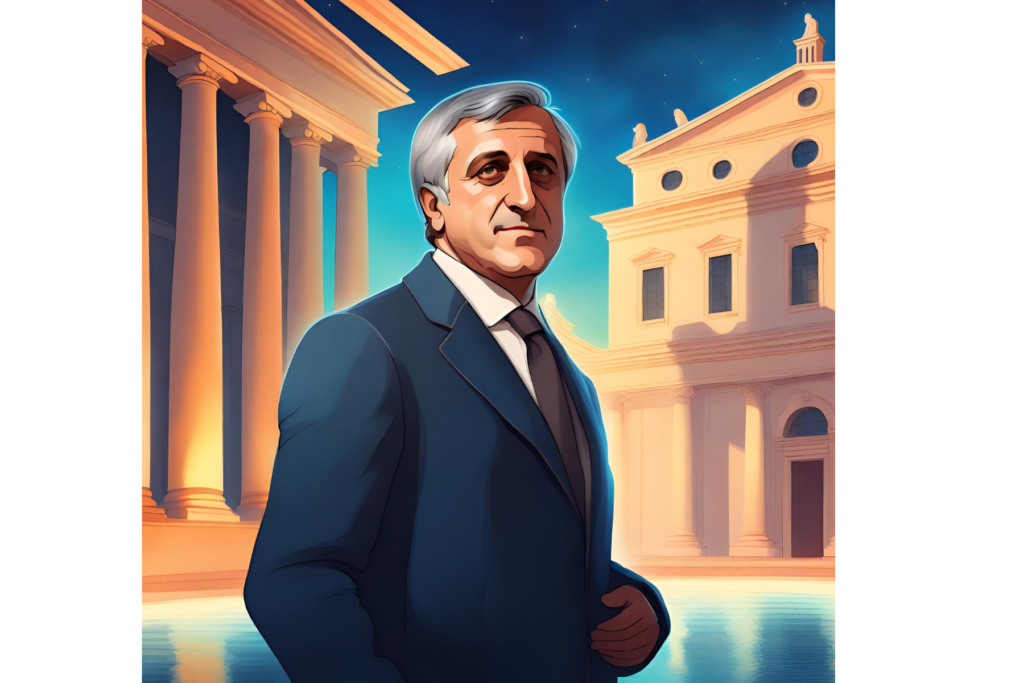

Il ministro degli Esteri Antonio Tajani secondo l’IA

Antonio Tajani. Nel ritratto fatto dall’Intelligenza Artificiale, spariscono i tratti somatici reali ma rimane la riconoscibilità del personaggio grazie a particolari come il taglio di capelli e il modo di vestire. Il ministro degli Esteri è quasi dentro uno specchio d’acqua, attorniato dalle colonne di un edificio classico e da quella che sembra una Chiesa.

Il ritratto che l’IA fa della premier Giorgia Meloni

Nessuna somiglianza, invece, per Giorgia Meloni o, meglio, per l’idea che ne ha l’Intelligenza Artificiale. La giovane che dovrebbe corrispondere a lei guarda l’obiettivo per uno scatto dal sapore veneziano, anche se più che la premier italiana sembra ritrarre l’attrice Anne Murphy. Alcuni particolari, tuttavia, fanno pensare all’esponente di FdI, come gli orecchini a goccia o lo scialle morbido dai toni pastello.

Matteo Renzi nella sua Firenze nello “scatto” immaginario generato dall’IA

Matteo Renzi o, meglio, l’idea che si è fatta di lui l’Intelligenza Artificiale, è invece ritratto nella sua Firenze. Anche qui più che i tratti somatici sono i particolari riconoscibili a farla da padrone, e infatti l’esponente di Italia Viva – Renew Europe è ritratto con la classica camicia col colletto sbottonato e con le tempie imbiancate.

Un Matteo Salvini irriconoscibile quello rappresentato dall’IA

L’altro Matteo, Salvini, sarebbe invece irriconoscibile se non fosse per il pizzetto e per l’evocativo Ponte sullo Stretto che si staglia sullo sfondo. Il ministro alle Infrastrutture nel ritratto che ne fa l’Intelligenza Artificiale appare con gli occhi azzurri, appesantito e con lo sguardo perso nel vuoto.

L’unico Conte che l’IA sembra conoscere è Antonio, l’allenatore di calcio

Giuseppe Conte, invece, come direbbe un agguerrito direttore, “non esiste”. L’Intelligenza artificiale ne fa un ritratto alquanto esilarante e sembra scambiarlo con un altro Conte, l’allenatore Antonio. Unica concessione: le stelle del partito, che spiccano – enormi – come nella reclame di una famosa marca di biscotti.

TECH

Pasticcio Ue

sull’AI Act

Il 13 marzo 2024 il Parlamento europeo ha approvato l’AI Act. Cosa cambierà? Secondo gli avvocati Lydia Mendola, Luca Tormen e Francesca Ellena, l’iter legislativo in realtà non è ancora completo e per la sua piena applicabilità ci vorranno alcuni anni, con la conseguenza che la norma nasca obsoleta.

“Il testo dell’AI Act – affermano gli avvocati – è tuttora soggetto a un controllo finale e manca l’approvazione del Consiglio europeo. Anche i tempi di entrata in vigore degli obblighi e delle sanzioni previsti dal testo di legge non sono immediati, posto che l’AI Act entrerà in vigore 20 giorni dopo la pubblicazione nella Gazzetta ufficiale e sarà pienamente applicabile solo 24 mesi dopo la sua entrata in vigore, ad eccezione di alcune previsioni che prevedono tempistiche ancora più lunghe: le previsioni sulle applicazioni AI vietate (6 mesi dopo la data di entrata in vigore); le previsioni sui codici di condotta (9 mesi dopo l’entrata in vigore); le regole AI di portata generale, compresa la governance (12 mesi dopo l’entrata in vigore) e gli obblighi per i sistemi AI ad alto rischio (36 mesi dopo l’entrata in vigore). E proprio questa scaletta temporale ha sollevato alcuni commenti negativi, perché la norma rischierebbe di nascere obsoleta.”

Chi sono i destinatari del Regolamento?

“Sono gli sviluppatori/fornitori (providers), i distributori, i produttori, gli importatori di sistemi di intelligenza artificiale, anche con sede fuori dall’Unione europea purché utilizzino dati di soggetti residenti nel territorio europeo o offrano servizi a questi ultimi (si parla di efficacia extra-territoriale del Regolamento). Ci sono poi previsioni anche per gli utilizzatori (deployers) di sistemi di intelligenza artificiale.”

Quali sono gli obblighi di natura tecnica in capo ai soggetti interessati?

“Essenzialmente, la maggior parte degli obblighi sono posti a carico dei provider di sistemi di AI. Ad esempio, sono i provider di sistemi di general purpose AI a dover soddisfare gli obblighi di disclosure previsti dal Regolamento (e.g. pubblicazione dei contenuti usati per il training per le verifiche copyright, messa disposizione di documentazione tecnica e istruzioni per l’uso), così come sono i provider di sistemi di AI ad alto rischio a dover condurre valutazioni di rischio, assicurare supervisione umana dei sistemi e gestire le richieste di informazioni dei cittadini. Le sanzioni previste per Il mancato rispetto di questa normativa sono significative. A seconda della gravità della violazione, è infatti previsto che le sanzioni varino in un range tra 10 e 40 milioni di euro o tra il 2% e il 7% del fatturato annuo globale dell’azienda.”

TECH

Amazon umanizza Alexa per l’8 marzo

Ogni giorno Alexa – l’assistente vocale di Amazon – riceve diverse richieste e a quanto pare anche insulti. Un’indagine condotta nell’ambito di una partnership con ActionAid racconta che in molti oltre a interrogarla la fanno diventare bersaglio di frasi poco gradevoli. E, per quanto Alexa sia un oggetto inanimato privo di identità e coscienza, Amazon ha pensato di approfittare della ricorrenza dell’8 marzo per “farla rispondere alle offese”. Un’idea che a detta della Big Tech contribuirà ad arginare la violenza verbale contro le donne.

“Si parla di violenza verbale – dicono i promotori dell’iniziativa – quando gli attacchi rivolti a una persona diventano regolari e sistematici. La violenza verbale può essere agita nella sfera pubblica (in cui è compreso anche lo spazio online) e privata e può includere atteggiamenti umilianti, ridicolizzanti, uso di parolacce, insulti e minacce nei confronti della vittima e dei suoi cari, ma può avere come oggetto anche religione, cultura, lingua, orientamento sessuale della vittima. A seconda delle aree emotivamente più sensibili della vittima, l’autore di violenza sceglie consapevolmente quale argomento utilizzare per agire violenza”.

Da qui, l’idea di permettere ad Alexa di “rispondere” agli insulti. Succederà a partire da oggi, 8 marzo, quando “Alexa risponderà a tono”, fanno sapere da Amazon , “sottolineando come la violenza verbale sia in grado di lasciare un’impronta su chi ne diventa oggetto“. Non solo: pronunciando le parole “Alexa, dì la tua”, partiranno dei messaggi preimpostati per “ascoltare informazioni e approfondimenti legati al fenomeno della violenza”.

TECH

L’orrore dentro Gaza e la tecnologia omicida. Così l’IA fabbrica 100 obiettivi militari al giorno

L’uso dell’intelligenza artificiale in campo militare sta sollevando importanti questioni etiche, a partire dall’utilizzo da parte di Israele nei raid. Prima dell’utilizzo dell’IA nei conflitti, aveva spiegato lo scorso anno in una intervista ad Ynet il capo del personale delle Idf Aviv Kochavi, gli obiettivi militari generati erano circa 50 all’anno. Adesso si arriva senza difficoltà a 100 obiettivi militari al giorno. Questo aumento esponenziale e questo utilizzo fuori controllo della tecnologia sono la causa, rileva Lorenzo Forlani dalle colonne del Fatto Quotidiano, di una vera e propria “fabbrica di omicidi di massa“.

L’IA è uno strumento potente per la generazione di obiettivi militari sfruttato dalle intelligence di tutto il mondo. Attraverso complessi algoritmi di riconoscimento delle immagini e di analisi dei dati, i sistemi basati sull’Intelligenza Artificiale possono identificare in modo rapido e preciso possibili bersagli. Grazie alla loro rapidità di elaborazione, questi algoritmi possono generare una quantità impressionante di obiettivi militarmente sensibili ogni giorno. E’ chiaro, però, che l’IA non è in grado di tenere conto – né mai lo sarà – dei risvolti etici, di comprendere quali siano i risultati degli attacchi e di considerare i danni gravissimi e spesso letali che si infliggono a intere popolazioni.

L’uso dell’IA nella generazione di obiettivi militari solleva infatti preoccupazioni legate alla responsabilità e all’impatto umanitario. Le decisioni relative all’utilizzo di obiettivi militari generati tramite IA richiedono un’adeguata ponderazione delle conseguenze e delle implicazioni reali. Mentre l’IA può fornire informazioni utili per guidare le operazioni militari o prevenirle, la decisione di agire deve ancora appartenere agli esseri umani, in modo da garantire il rispetto per i diritti umani e dei trattati internazionali e la sicurezza dei civili.